近日,本实验室谭建荣院士、张树有教授团队在工业机器人视觉方面的最新研究成果,在《IEEE Transactions on Robotics》上以学术长文(regular paper)的形式发表,题为“ContourPose: Monocular 6-D Pose Estimation Method for Reflective Textureless Metal Parts”。何再兴副教授为论文的第一作者、赵昕玥副教授为论文的通讯作者。

研究背景

论文主要研究面向工业机器人智能化自主作业的强反光低纹理目标6自由度位姿与姿态(6D位姿)估计问题。要实现机器人的智能化自主作业,核心关键问题之一是要感知(一般用2D/3D视觉)待操作的目标,理解其在机器人空间中的 6D位姿。6D位姿估计的效果严重依赖于物体的表面特性(这里主要指图像特性),对位姿估计的影响主要有两种属性:纹理丰富和表面粗糙程度。物体表面是否具有可利用的图像纹理、表面是否粗糙(漫反射),决定了物体6D位姿估计的难度。具有丰富纹理表面的物体可以利用2D相机中图像特征点匹配的关系获得精确可靠的6D位姿信息;粗糙表面物体可以利用结构光获取准确的3维点云进而再计算其6D位姿。GRB-D相机兼有2D和3D图像信息,再结合相应的算法是处理具有这两类表面属性之一的一般物体的常用技术手段。低纹理反光表面既没有可用的显性纹理、其隐性纹理也受到反光的强烈干扰,另外镜面反射效应还会导致结构光等三维测量方法失效从而导致点云大量缺失。因此即具有强反光、又不具有丰富纹理信息的物体是现有技术难以处理的对象,这类目标的6D位姿估计问题是学术界公认的世界级难题。而具有这两种表面属性的物体(如机械零件等)在制造业中大量存在,同时工业应用对6D估计技术的鲁棒性和精度比一般通用领域更高。这是导致在实际制造加工过程中,机器人智能化自主作业的主要技术瓶颈之一。

主要创新

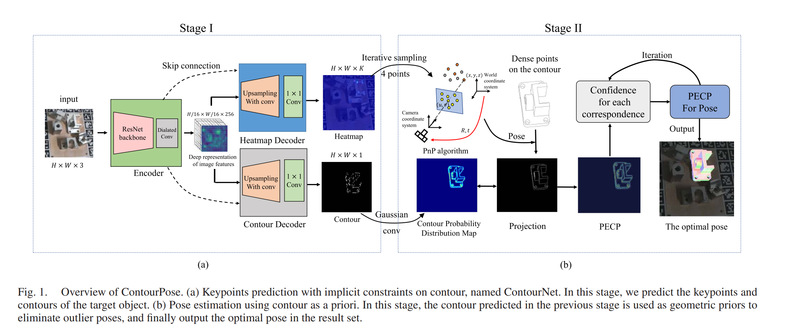

利用点特征匹配结合深度神经网络来计算物体的6D位姿是通用领域的主流方法之一,然而在用于反光低纹理表面物体时,产生的主要问题就是关键点的不可靠,这对于位姿估计的结果影响是致命的。具体而言,会在两个关键环节产生严重的问题:(1)在图像中物体的关键点预测阶段,由于反光造成图像特征的改变,神经网络预测的关键点准确性比较低;(2)在6D位姿解算阶段,正确的关键点比例低,导致难以计算出正确的位姿、即使计算出来也难以判断位姿计算的结果是否正确。论文的主要思想是引入反光低纹理目标零件的可靠、鲁棒信息:轮廓。这一灵感来源于人类对物体的识别,往往只需要轮廓信息。而机械零件的轮廓正是在反光干扰下的唯一可靠信息。基于这一原理,作者设计了新的神经网络架构,在两个关键环节使用轮廓信息以提高位姿估计的准确性与精度(Fig. 1):(1)提出了一种轮廓约束的反光金属零件关键点检测深度学习框架:在关键点预测阶段,利用轮廓约束提高关键点预测的准确性。(2)提出了一种基于轮廓先验的位姿优化方法:在位姿估计阶段,将轮廓的重投影重合度作为位姿估计准确性的判断,从而可以在较低正确比例关键点的情况下,也能判断并获得准确的6D位姿。

实验结果

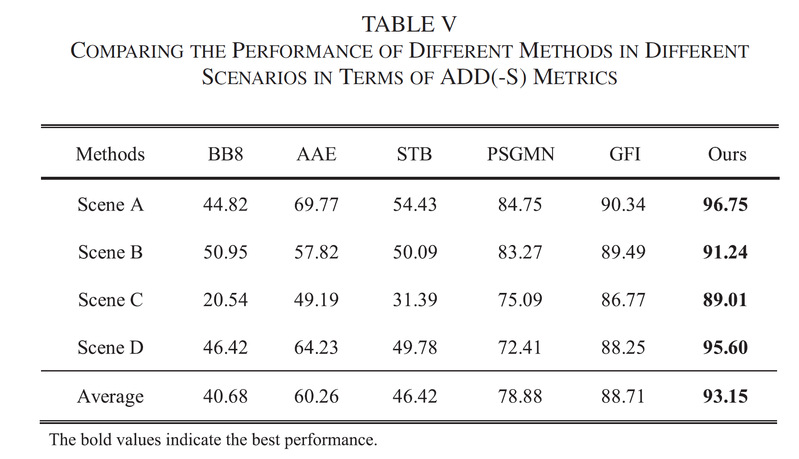

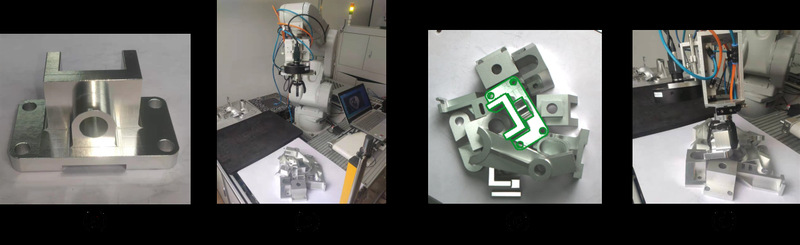

以10个反光金属零件为对象构建了数据集,包含4个不同场景,从位姿估计成功率(误差小于零件尺寸10%视为成功)和位姿估计精度两方面对本文方法和现有主流方法BB8、AAE、STB、PSGMN、GFI等进行了对比,实验结果(Table V、VI)表明本文方法不论是成功率和精度都大幅优于现有方法。本方法可以有效引导工业机器人在复杂场景下对目标零件进行抓取等智能自主操作(Fig. 16)。

Figure.16. Illustration of grasping task of reflective metal parts in complex scene. (a) The metal part to grasp. (b) Initial position of the industrial robot. (c) Image taken by the camera at the initial position. The proposed method successfully estimates the 6D pose of the target part. (d) Successful grasping of the metal part。

面向工业机器人智能化自主作业,针对反光低纹理目标的识别与6D位姿估计问题,课题组开展了多年的研究,连续提出了基于几何特征、生成式模型等反光低纹理目标识别与位姿估计理论、模型与方法。相关研究请参考以下论文:

[1] Z He, Q Li, X Zhao, J Wang, H Shen, S Zhang, and J Tan. ContourPose: Monocular 6D pose estimation method for reflective texture-less metal parts, IEEE Transactions on Robotics, 2023, Early Access.

[2] Z He, Y Chao, M Wu, Y Hu, and X Zhao. G-GOP: Generative Pose Estimation of Reflective Texture-Less Metal Parts With Global-Observation-Point Priors, IEEE-ASME Transactions on Mechatronics, 2023, Early Access.

[3] Z He, M Wu, X Zhao, S Zhang, J Tan. A generative feature-to-image robotic vision framework for 6-D pose estimation of metal parts, IEEE-ASME Transactions on Mechatronics, 2022-10, 27(5), 3198-3209.

[4] J Jiang, Z He, X Zhao, S Zhang, C Wu and Y Wang, REG-Net: Improving 6DoF Object Pose Estimation with 2D Keypoint Long-Short-Range-Aware Registration, IEEE Transactions on Industrial Informatics, Published Online, 2023, 19(1), 328 - 338.

[5] Z He, Z Jiang, X Zhao, S Zhang, C Wu, Sparse template-based 6D pose estimation of metal parts using a monocular camera, IEEE Transactions on Industrial Electronics, 2020-01, 67(1), 390-401.

[6] Z He, C Wu, S Zhang, X Zhao, Moment-based 2 1/2D visual servoing for textureless planar part grasping, IEEE Transactions on Industrial Electronics, 2019-10, 66(10), 7821-7830.